Il passaggio al raffreddamento a liquido non è un costo, ma l’investimento più redditizio per il tuo data center AI, con un TCO inferiore fino al 27% in 5 anni rispetto all’aria.

- Riduce drasticamente i costi energetici legati al raffreddamento, che possono rappresentare fino al 40% della bolletta di un data center.

- Permette di raggiungere un Power Usage Effectiveness (PUE) inferiore a 1.2, allineandosi alle direttive europee e migliorando il reporting ESG.

- Trasforma il calore di scarto da problema costoso a risorsa valorizzabile, ad esempio per il riscaldamento degli uffici aziendali.

Raccomandazione: Valutare la transizione non solo sul CAPEX iniziale, ma sul Total Cost of Ownership (TCO) a 5 anni per cogliere il reale vantaggio finanziario e strategico.

I rack dei tuoi server AI diventano incandescenti e la bolletta elettrica segue la stessa curva esponenziale. È una scena fin troppo familiare per ogni CTO che gestisce carichi di lavoro legati all’High Performance Computing (HPC). Le GPU e le CPU di ultima generazione, indispensabili per l’intelligenza artificiale, generano una densità termica che i tradizionali sistemi di raffreddamento ad aria faticano a gestire in modo efficiente. La soluzione classica, ovvero potenziare i condizionatori (CRAC/CRAH) e aumentare la velocità delle ventole, non fa che aggravare il problema: il consumo energetico schizza alle stelle, l’efficienza complessiva del data center (misurata dal PUE) peggiora e i costi operativi diventano insostenibili.

In questo scenario, la discussione sul raffreddamento a liquido è uscita dai laboratori di ricerca per entrare prepotentemente nelle sale riunioni dei consigli di amministrazione. Ma se la vera soluzione non fosse raffreddare *di più*, ma raffreddare *meglio*? E se il calore, da nemico da espellere, potesse diventare un asset strategico per l’azienda? È qui che il raffreddamento a liquido cambia le regole del gioco. Non si tratta più solo di una scelta tecnologica per pochi pionieri, ma di una decisione strategica imprescindibile per garantire la sostenibilità, sia finanziaria che ambientale, del proprio centro di calcolo. Questo non è un semplice upgrade, ma un cambio di paradigma che impatta TCO, efficienza operativa e persino la brand reputation.

In questo articolo analizzeremo in modo strategico, dati alla mano, perché il passaggio al raffreddamento a liquido è una mossa non più rimandabile per chiunque operi con infrastrutture AI. Esploreremo le diverse tecnologie, i reali risparmi economici, i vantaggi operativi e le implicazioni pratiche per adattare una sala server esistente.

Sommario: L’analisi completa del raffreddamento a liquido per data center AI

- Direct-to-Chip vs Immersione: quale sistema di raffreddamento liquido è più sicuro e manutenibile?

- Power Usage Effectiveness: come abbassare il tuo indice sotto 1.2 grazie al liquido

- L’errore di temere le perdite: come i moderni liquidi dielettrici proteggono l’hardware

- Come riutilizzare l’acqua calda dei server per riscaldare gli uffici aziendali

- Adattare una sala server esistente: quali modifiche idrauliche servono per passare al liquido?

- Come raffreddare processori spinti al limite per mantenere la stabilità operativa

- Calcolatori di emissioni: come quantificare la CO2 prodotta dal tuo sito web e dalla posta elettronica

- Come ridurre la bolletta energetica IT del 20% applicando policy di Green IT concrete?

Direct-to-Chip vs Immersione: quale sistema di raffreddamento liquido è più sicuro e manutenibile?

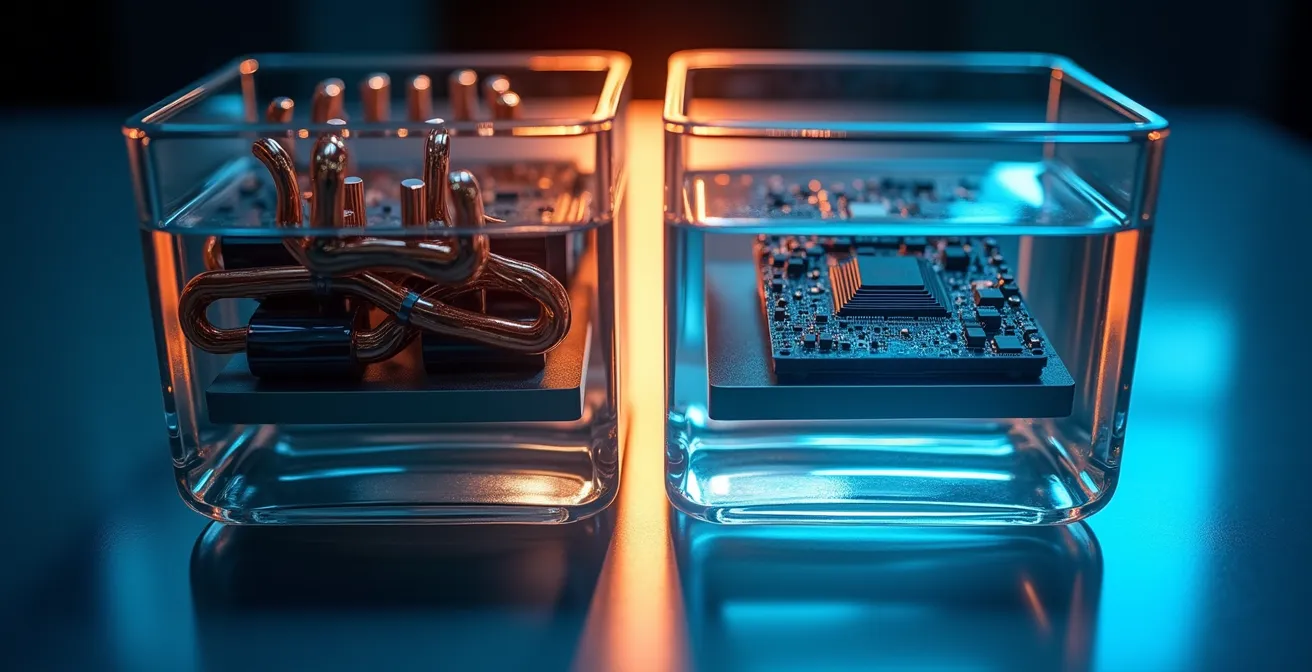

La transizione verso il raffreddamento a liquido non è una scelta monolitica. Le due principali tecnologie sul mercato, Direct-to-Chip (DTC) e Immersione, offrono approcci radicalmente diversi alla gestione del calore. Il DTC, come suggerisce il nome, utilizza delle “cold plates” a contatto diretto con i componenti più caldi (CPU, GPU) attraverso cui circola un liquido refrigerante. L’immersione, invece, prevede di sommergere l’intero server in un bagno di liquido dielettrico non conduttivo. La scelta tra i due sistemi non è solo tecnica, ma strategica, e dipende da fattori come la densità dei rack, le competenze del personale e la propensione al rischio. L’adozione sta accelerando: una crescita che, secondo i dati di Mordor Intelligence, vedrà il raffreddamento a liquido coprire il 46% del mercato globale entro la fine del 2024.

Come evidenziato dallo schema, il sistema DTC si integra in modo più “tradizionale” all’interno dei rack standard, facilitando l’accesso ai componenti per la manutenzione. Al contrario, l’immersione richiede procedure specifiche per estrarre e intervenire sull’hardware, ma offre una dissipazione del calore uniforme e superiore. La manutenibilità diventa quindi un criterio decisionale chiave.

Per un CTO, la decisione deve basarsi su un’analisi pragmatica dei pro e contro di ogni soluzione in termini di operatività quotidiana. Il seguente confronto delinea i principali criteri di valutazione.

| Criterio | Direct-to-Chip | Immersione |

|---|---|---|

| Complessità manutenzione | Media – richiede tecnici specializzati per tubazioni | Alta – necessità di gestire fluidi dielettrici |

| Rischio perdite | Presente ma localizzato | Minimo – hardware completamente immerso |

| Accessibilità componenti | Buona – accesso diretto ai server | Limitata – necessità di estrarre dall’immersione |

| Competenze richieste | Idraulica specializzata + IT | Gestione fluidi speciali + IT |

Power Usage Effectiveness: come abbassare il tuo indice sotto 1.2 grazie al liquido

Il Power Usage Effectiveness (PUE) è la metrica regina per misurare l’efficienza energetica di un data center. Un PUE di 2.0 significa che per ogni watt destinato all’IT, un altro watt viene sprecato in raffreddamento e altre infrastrutture. Un PUE di 1.0 rappresenta l’efficienza perfetta. I sistemi di raffreddamento ad aria tradizionali, specialmente in data center ad alta densità, faticano a scendere sotto un PUE di 1.6-1.8. Questo non è solo inefficiente, ma sta diventando insostenibile anche dal punto di vista normativo. L’Unione Europea, con il suo forte impegno verso la sostenibilità, sta spingendo per standard sempre più stringenti, come dimostra l’obiettivo che fissa un PUE massimo di 1,2 per tutti i nuovi data center entro il 2030.

Il raffreddamento a liquido è l’unica tecnologia in grado di raggiungere e superare questi obiettivi in modo consistente. Poiché l’acqua e altri liquidi hanno una capacità termica circa 3.500 volte superiore a quella dell’aria, il trasferimento di calore è immensamente più efficiente. Questo permette di eliminare quasi completamente i costosi e energivori sistemi di condizionamento, riducendo drasticamente l’energia consumata dall’infrastruttura di raffreddamento. Di conseguenza, il denominatore dell’equazione del PUE (Energia Totale Impianto / Energia Apparati IT) si avvicina notevolmente al numeratore. Le performance raggiungibili sono notevoli, come sottolineano gli esperti del settore.

Il raffreddamento a liquido può raggiungere un PUE di 1,05, avvicinandosi all’efficienza perfetta

– Opteon Technologies, Liquid Cooling Solutions for Data Centers

Raggiungere un PUE inferiore a 1.2 non è più un’utopia, ma un obiettivo concreto che trasforma il data center da un centro di costo energetico a un modello di efficienza. Questo ha un impatto diretto e misurabile sulla bolletta elettrica, ma anche un valore inestimabile per il reporting ESG (Environmental, Social, and Governance), sempre più cruciale per investitori e stakeholder.

L’errore di temere le perdite: come i moderni liquidi dielettrici proteggono l’hardware

Una delle principali barriere psicologiche all’adozione del raffreddamento a liquido è l’atavica paura di “acqua vicino all’elettronica”. Questo timore, sebbene comprensibile, si basa su un presupposto errato: che i liquidi utilizzati siano conduttivi come l’acqua del rubinetto. In realtà, soprattutto nei sistemi a immersione, si utilizzano fluidi dielettrici appositamente ingegnerizzati. Si tratta di composti sintetici che non conducono elettricità e sono chimicamente inerti, progettati per essere a contatto diretto con i componenti elettronici senza causare cortocircuiti o corrosione. Anche in caso di una perdita catastrofica, l’hardware non subirebbe alcun danno elettrico.

Questi fluidi non solo sono sicuri, ma offrono anche prestazioni termiche ineguagliabili. Nelle soluzioni di immersione bifase, il liquido bolle a una temperatura relativamente bassa (es. 50-60°C) direttamente sulla superficie dei chip. Questo processo di evaporazione, noto come “phase-change cooling”, assorbe un’enorme quantità di energia termica in modo incredibilmente efficiente. Il vapore sale, si condensa su una serpentina fredda e ricade nel bagno sotto forma di liquido, creando un ciclo di raffreddamento passivo e potentissimo. Studi recenti dimostrano la capacità di questi sistemi di dissipare carichi termici fino a 1500W per centimetro quadrato, ordini di grandezza superiori a quanto possibile con l’aria.

La gestione di questi fluidi richiede ovviamente nuove competenze e procedure, ma non è più un’arte oscura. La chiave sta nell’adottare protocolli di sicurezza e manutenzione rigorosi, formando il personale e implementando sistemi di monitoraggio adeguati. Superare la paura delle perdite significa aprire la porta a livelli di densità e efficienza altrimenti irraggiungibili.

Piano d’azione per la gestione sicura dei fluidi dielettrici

- Verificare la compatibilità dei materiali di tutta l’infrastruttura (guarnizioni, cavi, ecc.) con il fluido dielettrico scelto prima dell’implementazione.

- Utilizzare solo fluidi con un punto di ebollizione adeguato alla temperatura operativa massima del sistema per evitare evaporazioni indesiderate.

- Implementare sistemi di monitoraggio continuo per il livello, la qualità e la purezza del fluido, con allarmi automatici in caso di anomalie.

- Stabilire protocolli di manutenzione preventiva chiari, inclusa la filtrazione o la sostituzione periodica dei fluidi secondo le specifiche del produttore.

- Formare in modo approfondito il personale tecnico sulle procedure di manipolazione sicura, gestione delle emergenze e smaltimento dei fluidi esausti.

Come riutilizzare l’acqua calda dei server per riscaldare gli uffici aziendali

Nel paradigma del raffreddamento tradizionale ad aria, il calore generato dai server è un puro prodotto di scarto, un nemico da espellere nell’atmosfera con un enorme dispendio energetico. Il raffreddamento a liquido capovolge questa prospettiva: catturando il calore in modo molto più efficiente e a una temperatura più elevata, lo trasforma da rifiuto a risorsa energetica preziosa. L’acqua che esce da un circuito di raffreddamento a liquido può raggiungere i 60-65°C, una temperatura ideale per essere riutilizzata in svariati modi, trasformando il data center in una sorta di centrale termica.

L’applicazione più immediata e vantaggiosa è il riscaldamento degli spazi aziendali. Invece di pagare per smaltire il calore dei server e, contemporaneamente, pagare per produrre calore per gli uffici, si può creare un circuito virtuoso. L’acqua calda proveniente dai rack può essere convogliata direttamente nell’impianto di riscaldamento dell’edificio (ad esempio, pannelli radianti a pavimento o a soffitto), coprendo una parte significativa o addirittura la totalità del fabbisogno termico durante i mesi invernali. Questo approccio di recupero del calore non solo abbatte i costi energetici per il riscaldamento, ma migliora drasticamente l’impronta di carbonio complessiva dell’azienda.

Esistono esempi virtuosi su scala globale che dimostrano la fattibilità e i benefici di questo approccio, integrando il data center nell’ecosistema energetico circostante.

Studio di caso: Il sistema ATES del data center Equinix AM3 ad Amsterdam

Il data center AM3 di Equinix ad Amsterdam impiega un innovativo sistema chiamato ATES (Aquifer Thermal Energy Storage). Durante l’estate, il calore in eccesso non viene disperso ma viene utilizzato per riscaldare l’acqua, che viene poi immagazzinata in una falda acquifera sotterranea. Durante l’inverno, quest’acqua calda viene recuperata e utilizzata per riscaldare sia il data center stesso che gli edifici dell’adiacente Università di Amsterdam. Questo sistema a circuito chiuso permette non solo un enorme risparmio energetico, ma anche una simbiosi virtuosa con il territorio, dimostrando come il calore dei server possa diventare un asset per la comunità.

Oltre al riscaldamento degli uffici, altre possibili applicazioni includono la produzione di acqua calda sanitaria, il riscaldamento di serre agricole o l’integrazione in reti di teleriscaldamento urbano, come già avviene in alcuni paesi del Nord Europa. Per un CTO, questa non è più fantascienza, ma un’opportunità concreta di trasformare una delle maggiori voci di costo operativo in un centro di profitto o, quantomeno, in un drastico abbattimento dei costi.

Adattare una sala server esistente: quali modifiche idrauliche servono per passare al liquido?

Una delle maggiori preoccupazioni per un CTO è l’impatto di una transizione al raffreddamento a liquido su un data center esistente (retrofit). L’idea di dover sventrare la sala dati e fermare le operazioni per mesi è un deterrente significativo. Tuttavia, le moderne soluzioni di raffreddamento liquido, in particolare quelle Direct-to-Chip (DTC), sono state progettate proprio per minimizzare l’impatto e facilitare l’integrazione in ambienti già operativi. La buona notizia è che non è quasi mai necessario un rifacimento completo. In Italia, abbiamo esempi eccellenti come il campus di Aruba a Ponte San Pietro, dove il raffreddamento a liquido è stato implementato con successo in un ambiente già in produzione, senza richiedere spazi dedicati aggiuntivi o modifiche strutturali invasive.

Le modifiche principali riguardano l’impianto idraulico. È necessario installare delle Coolant Distribution Units (CDU), che agiscono come intermediari tra il circuito idraulico primario dell’edificio e i circuiti secondari che vanno ai rack. Le CDU gestiscono la temperatura, la pressione e il flusso del liquido refrigerante diretto ai server. Da queste unità partono le tubazioni (solitamente flessibili e con attacchi rapidi anti-goccia) che corrono lungo i rack, spesso alloggiate nel pavimento sopraelevato o in canaline aeree. Il punto chiave è che queste modifiche possono essere pianificate e realizzate in modo incrementale, rack per rack o fila per fila, minimizzando i downtime.

Prima di iniziare un progetto di retrofit, è fondamentale una fase di valutazione approfondita (assessment). Questa analisi deve considerare diversi aspetti pratici:

- Capacità strutturale del pavimento: Verificare che il pavimento sopraelevato possa sostenere il peso aggiuntivo delle tubazioni piene di liquido e delle CDU.

- Spazio per le infrastrutture: Identificare gli spazi per l’installazione delle CDU e degli scambiatori di calore esterni (dry cooler o torri evaporative).

- Compatibilità antincendio: Analizzare l’interazione con i sistemi antincendio esistenti e valutare se sono necessari aggiornamenti.

- Integrazione del monitoraggio: Pianificare come integrare i nuovi sensori di temperatura, flusso e perdite nel sistema di Building Management System (BMS) o Data Center Infrastructure Management (DCIM) esistente.

Un retrofit ben pianificato non è un salto nel buio, ma un processo ingegnerizzato che, pur richiedendo un investimento iniziale in termini di progettazione e impiantistica, sblocca benefici a lungo termine in termini di efficienza e scalabilità.

Come raffreddare processori spinti al limite per mantenere la stabilità operativa

Nei carichi di lavoro AI, le prestazioni sono tutto. Per massimizzare il ritorno sull’investimento hardware, CPU e GPU vengono spesso spinte ai loro limiti operativi tramite overclocking o operando costantemente a pieno carico. In queste condizioni, la stabilità diventa un problema critico. Un processore che supera la sua soglia termica di sicurezza (throttling) non solo riduce drasticamente le sue prestazioni, ma rischia anche un’usura precoce o un guasto improvviso. Il raffreddamento ad aria, in questi scenari ad altissima densità di potenza, mostra tutti i suoi limiti. L’aria semplicemente non ha la capacità fisica di rimuovere il calore abbastanza velocemente da una superficie così piccola e incandescente come un die di un processore moderno.

Il raffreddamento a liquido, specialmente il Direct-to-Chip, risolve questo problema alla radice. Applicando una cold plate direttamente sulla fonte di calore, il trasferimento termico è immediato ed estremamente efficace. Questo mantiene la temperatura del processore stabile e ben al di sotto della soglia di throttling, anche sotto il carico più intenso e prolungato. Il risultato è una performance sostenuta e prevedibile, che si traduce in tempi di elaborazione più brevi per i job di training AI e una maggiore affidabilità dell’intera infrastruttura. Secondo un’analisi dell’ASME (American Society of Mechanical Engineers), una transizione anche parziale dal raffreddamento ad aria a quello a liquido può ridurre il consumo energetico dell’impianto del 27%, in parte grazie alla maggiore stabilità che evita picchi di consumo.

La capacità di supportare densità di potenza per rack molto più elevate è uno dei vantaggi strategici più importanti. Dove l’aria fatica a superare i 30 kW per rack, il liquido apre le porte a densità di 100 kW e oltre.

Questo confronto mostra chiaramente come le tecnologie a liquido siano le uniche in grado di sostenere la roadmap evolutiva dei processori per AI e HPC.

| Tecnologia | Densità rack supportata | Crescita prevista |

|---|---|---|

| Raffreddamento ad aria tradizionale | < 30 kW | Limitata |

| Rear Door Heat Exchanger | 30-60 kW | Moderata |

| Direct-to-Chip liquido | 50-120 kW | CAGR 7.8% |

| Immersione completa | > 100 kW | Forte espansione |

Calcolatori di emissioni: come quantificare la CO2 prodotta dal tuo sito web e dalla posta elettronica

Nell’era della sostenibilità aziendale, misurare l’impatto ambientale delle proprie operazioni IT è diventato un imperativo. Non basta più affermare di essere “green”, bisogna dimostrarlo con dati quantificabili, specialmente nel reporting ESG. L’impronta di carbonio di un data center è determinata in gran parte dal suo consumo energetico, a sua volta influenzato pesantemente dal sistema di raffreddamento. Quantificare la riduzione di CO2 ottenibile con il passaggio al raffreddamento a liquido è quindi un esercizio cruciale per costruire un business case convincente.

Il calcolo è più semplice di quanto si possa pensare e si basa su una metodologia chiara. L’idea è confrontare le emissioni dello scenario attuale (“as-is”) con quelle dello scenario futuro (“to-be”) con il raffreddamento a liquido. I sistemi a immersione bifase, ad esempio, possono arrivare a ridurre fino al 90% il consumo energetico specifico per il raffreddamento, con un impatto diretto e massiccio sulla CO2 prodotta. Al di là dei server, è importante considerare che ogni attività digitale, dal sito web alla posta elettronica, ha un’impronta di carbonio legata all’energia consumata dai data center che la supportano. Ottimizzare il proprio centro di calcolo ha quindi un effetto a cascata su tutta l’impronta digitale dell’azienda.

Per quantificare la riduzione di emissioni di CO2 derivante dall’adozione del raffreddamento a liquido, è possibile seguire una metodologia precisa:

- Misurare il PUE attuale: Stabilire il Power Usage Effectiveness del data center con il sistema di raffreddamento ad aria esistente.

- Calcolare il consumo energetico annuale: Misurare il consumo totale in kWh del data center su base annua.

- Stimare le emissioni attuali: Moltiplicare il consumo energetico per il fattore di emissione del mix energetico nazionale. Per l’Italia, questo valore è di circa 250-300g di CO2 per kWh (valore in costante miglioramento grazie alle rinnovabili).

- Stimare il nuovo PUE: Definire il PUE target raggiungibile con la tecnologia a liquido scelta (es. 1.15 per DTC, 1.05 per immersione).

- Calcolare il nuovo consumo e le nuove emissioni: Sulla base del nuovo PUE, calcolare il nuovo consumo energetico annuale e le emissioni di CO2 corrispondenti.

- Quantificare il risparmio: La differenza tra le emissioni “as-is” e “to-be” rappresenta la riduzione di CO2 annuale, un dato potente da includere nel bilancio di sostenibilità.

Questo calcolo trasforma un beneficio tecnico (miglior PUE) in un valore tangibile e comunicabile (tonnellate di CO2 risparmiate), rafforzando l’immagine dell’azienda e il suo allineamento con gli obiettivi di neutralità climatica.

Punti chiave da ricordare

- Il passaggio al raffreddamento a liquido riduce il Total Cost of Ownership (TCO) fino al 27% su 5 anni rispetto all’aria, nonostante un CAPEX iniziale superiore.

- L’efficienza energetica migliora drasticamente, permettendo di raggiungere un PUE inferiore a 1.2, in linea con le normative europee e gli obiettivi ESG.

- Il calore di scarto dei server, da costo di smaltimento, si trasforma in una risorsa valorizzabile per il riscaldamento aziendale o il teleriscaldamento.

Come ridurre la bolletta energetica IT del 20% applicando policy di Green IT concrete?

Per un CTO, ogni discussione tecnologica deve alla fine tradursi in un’analisi di costi e benefici. La promessa di ridurre la bolletta energetica è allettante, ma deve essere supportata da un’analisi del Total Cost of Ownership (TCO) che vada oltre il semplice costo di acquisto (CAPEX). Il raffreddamento a liquido ha un CAPEX iniziale più elevato rispetto ai sistemi ad aria, questo è innegabile. Tuttavia, analizzando il TCO su un orizzonte di 5 anni, il quadro si ribalta completamente. I risparmi sui costi operativi (OPEX), principalmente legati al consumo energetico, sono così significativi da ammortizzare rapidamente l’investimento iniziale e generare un risparmio netto considerevole.

L’approccio deve essere olistico, combinando la tecnologia con policy di Green IT concrete. Questo significa non solo installare un sistema di raffreddamento efficiente, ma anche integrare pratiche di sostenibilità in tutto il ciclo di vita dell’IT. Esempi virtuosi, come il Global Cloud Data Center di Aruba a Ponte San Pietro, dimostrano la potenza di un approccio “green by design”. Il campus non solo utilizza un sistema di raffreddamento geotermico con acqua di falda, ma si auto-alimenta in parte con una centrale idroelettrica di proprietà e impianti fotovoltaici, puntando alla neutralità climatica entro il 2030 in linea con il Climate Neutral Data Center Pact.

L’analisi del TCO mette a confronto tutte le voci di costo, rivelando il vero vantaggio economico del passaggio al liquido.

Il seguente prospetto, basato su dati medi di mercato, illustra come un CAPEX più alto si traduca in un TCO significativamente più basso.

| Voce di costo | Sistema ad Aria | Sistema a Liquido | Differenza % |

|---|---|---|---|

| CAPEX iniziale | € 100.000 | € 150.000 | +50% |

| Costi energetici (5 anni) | € 500.000 | € 250.000 | -50% |

| Manutenzione | € 50.000 | € 75.000 | +50% |

| Spazio occupato (m²) | 200 | 100 | -50% |

| TCO totale | € 650.000 | € 475.000 | -27% |

Questo -27% sul TCO non è solo un numero: rappresenta risorse finanziarie liberate che possono essere reinvestite in innovazione, ricerca e sviluppo, invece che in bollette elettriche. La decisione di passare al liquido cessa di essere una spesa per l’IT e diventa un investimento strategico per la competitività e la sostenibilità dell’intera azienda.

Per tradurre questi vantaggi in un business case solido per la vostra organizzazione, il prossimo passo è avviare un’analisi di fattibilità e un calcolo del TCO specifico per la vostra infrastruttura. Questa valutazione vi fornirà i dati concreti per giustificare l’investimento e pianificare una transizione di successo verso un data center più efficiente, sostenibile e performante.