L’automazione di laboratorio non serve solo a ridurre i tempi, ma a costruire un ecosistema di “custodi digitali” che proteggono l’integrità di ogni campione e la validità di ogni dato.

- Il monitoraggio in tempo reale dei parametri critici (pH, T°, CO2) previene la perdita di mesi di lavoro su colture cellulari.

- I protocolli digitali e i sistemi LIMS eliminano la variabilità tra operatori e garantiscono la conformità normativa richiesta da AIFA/EMA.

Raccomandazione: Iniziare con un audit dei processi più ripetitivi e a rischio di errore umano per identificare il primo, cruciale passo verso un progetto pilota di automazione.

Per un responsabile di laboratorio biotech, poche cose sono più frustranti di una coltura cellulare contaminata o di un esperimento fallito dopo settimane di lavoro. La causa? Spesso una minima deviazione nei parametri ambientali, un errore di pipettaggio durante un protocollo lungo e ripetitivo, o un campione etichettato male. Il dibattito sull’automazione si concentra spesso sui benefici generici come l’aumento della produttività e la riduzione dei costi. Si parla di efficienza, di fare di più in meno tempo, quasi come se un laboratorio di ricerca fosse una catena di montaggio.

Questa visione, però, è incompleta. Manca il punto fondamentale per chi vive la scienza ogni giorno: la fiducia nel dato. E se la vera rivoluzione dell’automazione non fosse la velocità, ma la certezza sperimentale? Se ogni robot, sensore e software non fosse solo un esecutore, ma un guardiano attivo dell’integrità biologica del nostro lavoro? Questo è il cambio di paradigma: passare dal subire il rischio operativo al governarlo attraverso la tecnologia, trasformando la variabilità umana in riproducibilità computazionale.

Questo articolo esplora le diverse facce dell’automazione in un laboratorio italiano moderno, non come una raccolta di tecnologie a sé stanti, ma come componenti interconnessi di un unico sistema progettato per garantire l’affidabilità e la validità della ricerca scientifica. Analizzeremo come incubatori intelligenti, protocolli digitali, sistemi LIMS e persino l’edge computing contribuiscano a questo obiettivo cruciale.

Per navigare attraverso le complesse ma affascinanti soluzioni che la tecnologia offre oggi ai laboratori di ricerca, abbiamo strutturato questo approfondimento in aree tematiche specifiche. Il sommario seguente vi guiderà alla scoperta di come ogni aspetto dell’automazione contribuisca a rafforzare la qualità e la riproducibilità della vostra ricerca.

Sommario: Guida all’automazione per la certezza sperimentale in laboratorio

- Incubatori intelligenti: perché ricevere un alert sul cellulare se il pH cambia ti salva mesi di lavoro

- Bioprinting: quali file CAD servono per stampare una struttura vascolare complessa?

- LIMS (Laboratory Information Management System): l’errore di usare Excel per gestire 10.000 provette

- Riproducibilità della ricerca: come i protocolli digitali riducono la variabilità tra operatori

- Taratura pipette e robot: come pianificare la manutenzione senza fermare gli esperimenti

- IoT e vaccini: come monitorare la temperatura in tempo reale durante il trasporto

- Edge Computing: perché elaborare i dati vibrazionali direttamente sul sensore e non nel cloud

- Piattaforme di collaborazione scientifica: come condividere dati sensibili tra università e aziende?

Incubatori intelligenti: perché ricevere un alert sul cellulare se il pH cambia ti salva mesi di lavoro

L’incubatore a CO2 è il cuore pulsante di qualsiasi laboratorio di colture cellulari. Il suo compito non è semplicemente “tenere al caldo” i campioni, ma creare un micro-ambiente stabile che mima le condizioni fisiologiche. Una minima deviazione di temperatura, umidità o, soprattutto, di CO2 (che regola il pH del terreno di coltura) può compromettere la vitalità delle cellule e invalidare mesi di ricerca. Qui, l’automazione agisce come un sistema di sorveglianza attiva, un vero custode digitale. Gli incubatori moderni non si limitano a mantenere i parametri; li monitorano, li registrano e, soprattutto, allertano l’operatore in tempo reale.

Ricevere una notifica push sullo smartphone perché il livello di CO2 è sceso o la temperatura è salita non è una comodità, è una polizza assicurativa sul proprio lavoro. Permette di intervenire prima che il danno diventi irreversibile. Questa gestione proattiva si traduce anche in un’efficienza economica misurabile. Una gestione ottimizzata del gas, ad esempio, può generare un risparmio che, secondo le analisi di Eppendorf, può superare i 7.300€ in 5 anni solo sui costi del gas. Tecnologie avanzate come la doppia sterilizzazione termica a 180°C eliminano i tempi di inattività, permettendo la continuazione ininterrotta della coltura cellulare senza necessità di rimuovere parti interne o ricalibrare dopo il ciclo di sterilizzazione, massimizzando la produttività.

L’obiettivo non è solo mantenere i parametri nel range, ma garantire l’integrità biologica del campione in ogni istante. L’automazione trasforma l’incubatore da una scatola passiva a un partner attivo nella ricerca, che documenta ogni variazione e protegge l’investimento di tempo e risorse che ogni coltura rappresenta.

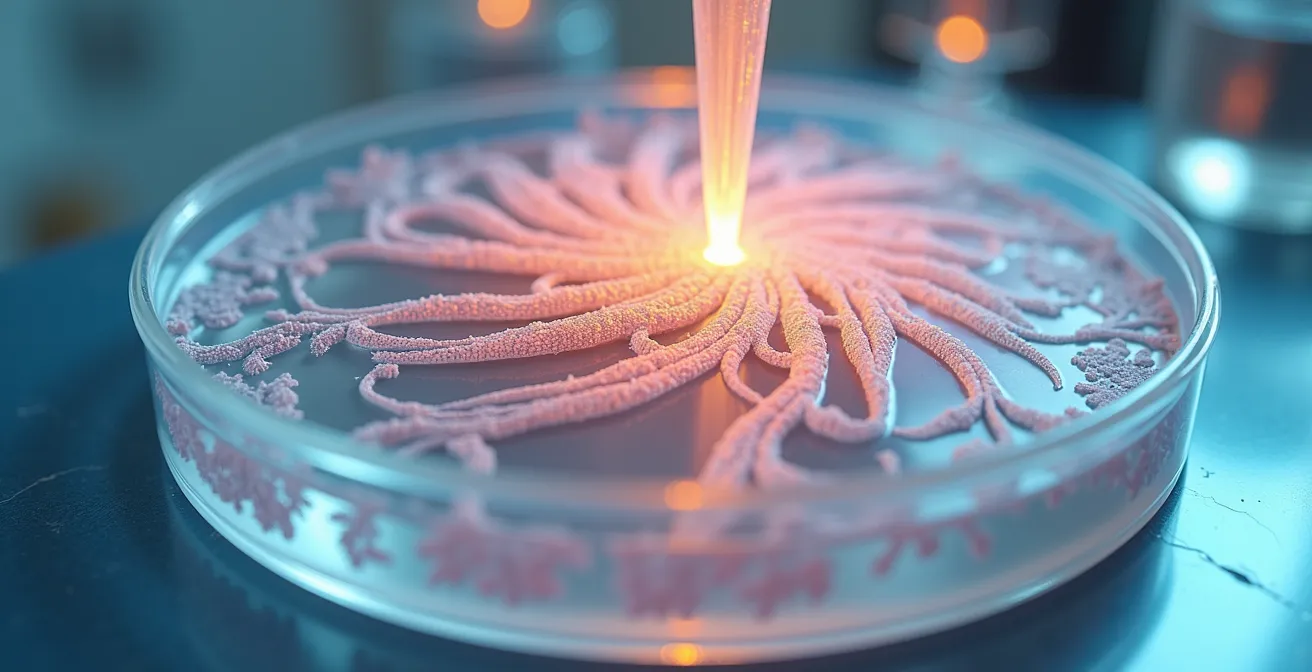

Bioprinting: quali file CAD servono per stampare una struttura vascolare complessa?

Il bioprinting 3D rappresenta una delle frontiere più avanzate della biotecnologia, con il potenziale di creare tessuti e organi funzionali. Stampare una struttura vascolare complessa, ad esempio, non è come stampare un oggetto di plastica; richiede una precisione sub-millimetrica e la capacità di depositare “bio-inchiostri” (gel contenenti cellule vive) in geometrie tridimensionali complesse. La base di tutto è un modello digitale, solitamente un file CAD (Computer-Aided Design).

Per strutture organiche complesse, i formati standard come STL (Stereolithography) sono spesso un punto di partenza, ma vengono integrati con dati derivati da imaging medicale (come TAC o RMN) per creare modelli paziente-specifici. Il software di slicing traduce poi questo modello 3D in una serie di istruzioni precise per il bioprinter, definendo il percorso dell’estrusore e il flusso di ogni bio-inchiostro. È qui che l’unione tra biologia e robotica diventa cruciale. L’innovazione italiana in questo campo è notevole; basti pensare ai ricercatori della Scuola Superiore Sant’Anna di Pisa, che hanno sviluppato soluzioni robotiche d’avanguardia per la manipolazione di tessuti a livello microscopico, dimostrando una padronanza della robotica collaborativa applicata alla biologia.

La sfida non è solo geometrica, ma anche biologica. Il protocollo di stampa deve garantire la vitalità delle cellule durante e dopo il processo. Ciò significa controllare la temperatura, la velocità di estrusione e la reticolazione del materiale. L’automazione non si limita a eseguire un file CAD; gestisce un “protocollo vivente” che tiene conto delle esigenze delle cellule, assicurando che la struttura stampata non sia solo anatomicamente corretta, ma biologicamente funzionale.

LIMS (Laboratory Information Management System): l’errore di usare Excel per gestire 10.000 provette

Man mano che un laboratorio cresce, la gestione dei campioni tramite fogli di calcolo come Excel diventa non solo inefficiente, ma pericolosa. Immaginate di dover tracciare 10.000 provette: un errore di copia-incolla, una formula cancellata o un salvataggio sovrascritto possono compromettere l’integrità di un intero studio. Excel non è stato progettato per garantire la Data Integrity richiesta da enti regolatori come AIFA (Agenzia Italiana del Farmaco) o EMA. Manca di un audit trail immutabile, di una gestione degli accessi basata sui ruoli e di una tracciabilità automatica.

Un LIMS (Laboratory Information Management System) è la risposta strutturata a questa complessità. Non è un semplice database, ma un sistema nervoso centrale per il laboratorio. Ogni campione riceve un identificatore univoco (solitamente un codice a barre), e ogni sua movimentazione, analisi o stoccaggio viene registrata automaticamente. Questo crea una cronologia completa e a prova di manomissione, fondamentale per la conformità GxP (Good x Practice). I sistemi moderni, spesso basati su cloud, offrono modelli pay-per-use scalabili, rendendoli accessibili anche a PMI e laboratori universitari.

Il passaggio da Excel a un LIMS non è un semplice upgrade tecnologico, ma un cambiamento culturale verso la fiducia computazionale. Significa affidare la gestione dei dati a un sistema progettato per essere rigoroso e infallibile, liberando i ricercatori dal lavoro manuale di tracciamento e permettendo loro di concentrarsi sull’analisi e l’interpretazione scientifica.

Per comprendere meglio il divario, un’analisi comparativa mette in luce le differenze operative chiave, come dimostra una recente analisi delle soluzioni di gestione dei dati.

| Caratteristica | Excel | LIMS Cloud |

|---|---|---|

| Tracciabilità campioni | Manuale, rischio errori | Automatica con barcode |

| Conformità AIFA/EMA | Non garantita | Data Integrity certificata |

| Gestione multi-utente | Limitata | Accesso simultaneo sicuro |

| Audit trail | Assente | Completo e immutabile |

| Costo PMI/università | Gratuito iniziale | Pay-per-use scalabile |

Riproducibilità della ricerca: come i protocolli digitali riducono la variabilità tra operatori

La crisi della riproducibilità è uno dei problemi più sentiti nella comunità scientifica. Studi diversi che dovrebbero dare gli stessi risultati spesso falliscono nel farlo, e una delle cause principali è la variabilità nell’esecuzione dei protocolli. Due ricercatori, pur seguendo lo stesso documento cartaceo, possono interpretare un passaggio in modo leggermente diverso, usare tecniche di pipettaggio differenti o avere tempistiche non identiche. Queste micro-variazioni si accumulano, portando a risultati divergenti.

I protocolli digitali eseguiti da un robot di pipettaggio eliminano questa variabilità. Un protocollo digitalizzato non è un semplice PDF, ma uno script eseguibile che detta ogni azione del robot: quale reagente prelevare, quale volume, in quale pozzetto depositarlo e con quale velocità. L’esecuzione è identica ogni singola volta, indipendentemente dall’operatore che avvia il processo. Questo non solo garantisce la riproducibilità tra diversi esperimenti nello stesso laboratorio, ma anche tra laboratori diversi che utilizzano lo stesso sistema. Il crescente ecosistema italiano, con i suoi 270 incubatori e acceleratori attivi evidenziati dal report 2024 di Social Innovation Monitor, fornisce il terreno fertile per l’adozione di questi standard elevati.

Sistemi avanzati integrano funzionalità come il “Method Recovery”, che consente a un run interrotto (ad esempio per un’interruzione di corrente) di riprendere esattamente da dove si era fermato, salvando campioni e reagenti preziosi. L’interfaccia può includere video e SOP (Standard Operating Procedures) per guidare l’operatore nella preparazione, riducendo ulteriormente il rischio di errori. La validazione finale avviene tramite test gravimetrici automatizzati, che verificano che il volume pipettato dal robot sia accurato e preciso, chiudendo il cerchio della fiducia computazionale.

Il tuo piano d’azione per la digitalizzazione dei protocolli

- Digitalizzare i protocolli cartacei esistenti in un formato ELN (Electronic Lab Notebook) per centralizzarli.

- Convertire le procedure standardizzate in script eseguibili da un robot di pipettaggio compatibile.

- Implementare sistemi con Method Recovery per garantire la continuità operativa anche in caso di interruzioni.

- Integrare supporti multimediali (foto, video, SOP) direttamente nell’interfaccia del software di automazione per guidare l’operatore.

- Validare periodicamente la riproducibilità e l’accuratezza del sistema robotico con test gravimetrici automatizzati.

Taratura pipette e robot: come pianificare la manutenzione senza fermare gli esperimenti

Uno strumento non calibrato è peggio di uno strumento rotto, perché produce dati errati che sembrano corretti. Nell’automazione di laboratorio, la taratura periodica di pipette e bracci robotici non è un’incombenza, ma un pilastro della validità dei dati. Un robot di pipettaggio che eroga costantemente 9.8 µL invece di 10 µL può sembrare una deviazione minima, ma in un saggio qPCR o in una diluizione seriale, questo errore sistematico si amplifica, portando a conclusioni scientifiche errate.

La pianificazione della manutenzione diventa quindi un atto strategico. L’obiettivo è integrarla nel flusso di lavoro senza causare fermi macchina prolungati. Molti sistemi moderni includono software di diagnostica che monitorano le prestazioni e suggeriscono quando è necessaria la manutenzione. Si possono programmare interventi di taratura in periodi di bassa attività o utilizzare sistemi modulari che permettono di sostituire una testa di pipettaggio con una già calibrata mentre la prima viene manutenuta. Per strumenti ad alto utilizzo, la frequenza è fondamentale: per le pipette utilizzate regolarmente, esperti come Gilson raccomandano controlli e potenziali ricalibrazioni da 3 a 4 volte l’anno.

L’automazione stessa può supportare la manutenzione. Esistono sistemi robotizzati che eseguono test di calibrazione gravimetrica in modo automatico durante la notte, generando un report di conformità pronto al mattino. La pianificazione non riguarda solo la prevenzione dei guasti, ma il mantenimento di un livello costante e documentato di accuratezza, essenziale per la riproducibilità e la conformità. Questo approccio proattivo è ciò che permette a un grande laboratorio italiano di gestire fino a 400 campioni al giorno con un sistema robotico per l’analisi TAN/TBN, garantendo che l’alto volume non vada mai a discapito della precisione.

IoT e vaccini: come monitorare la temperatura in tempo reale durante il trasporto

La catena del freddo è un esempio lampante di come l’integrità biologica di un prodotto dipenda da un monitoraggio costante. Un vaccino o un farmaco biologico esposto a una temperatura errata, anche per un breve periodo, può perdere la sua efficacia. Il monitoraggio tradizionale con data logger che vengono letti solo all’arrivo è un approccio reattivo: si può solo constatare se c’è stato un problema, non prevenirlo. L’Internet of Things (IoT) rivoluziona questo paradigma introducendo il monitoraggio in tempo reale.

Sensori IoT posizionati all’interno dei contenitori di trasporto misurano costantemente la temperatura e trasmettono i dati a una piattaforma cloud tramite reti cellulari. Se la temperatura esce dal range predefinito (es. 2-8 °C), il sistema invia un allarme immediato al responsabile della logistica. Questo permette di intervenire, ad esempio contattando l’autista o attivando un sistema di raffreddamento di backup, prima che il prodotto sia compromesso. Lo stesso principio si applica agli incubatori e ai frigoriferi in laboratorio, dove il controllo dell’umidità è altrettanto critico. Ad esempio, a 37°C con il 95% di umidità relativa, una condizione tipica per le colture cellulari, la temperatura di condensazione è di circa 36°C, il cosiddetto punto di rugiada. Un monitoraggio impreciso potrebbe portare a una condensazione indesiderata, alterando l’osmolarità del terreno e stressando le cellule.

Questa capacità di “vedere” e “agire” a distanza trasforma la gestione della catena del freddo da una scommessa a un processo controllato. L’integrazione di questi sensori in un sistema di monitoraggio centrale (come un RMS – Rotronic Monitoring System) permette di avere una visione d’insieme su più siti, garantendo la conformità e fornendo un audit trail digitale completo per ogni spedizione, un requisito fondamentale in un settore altamente regolamentato come quello farmaceutico, con piena attenzione alla conformità GDPR per i dati sensibili.

Da ricordare

- Il monitoraggio in tempo reale dei parametri ambientali (pH, T°, umidità) è una forma di prevenzione attiva che salva esperimenti e risorse.

- I protocolli digitali e robotizzati sono la chiave per eliminare la variabilità tra operatori, un passo fondamentale verso una vera riproducibilità scientifica.

- La manutenzione e la taratura non sono interruzioni del lavoro, ma investimenti strategici per garantire l’accuratezza e l’affidabilità di ogni dato prodotto.

Edge Computing: perché elaborare i dati vibrazionali direttamente sul sensore e non nel cloud

I laboratori moderni generano una quantità enorme di dati. Pensiamo a un sequenziatore di nuova generazione o a un microscopio confocale. L’approccio tradizionale consiste nel mandare tutti questi dati grezzi a un server centrale o al cloud per l’elaborazione. Questo, però, può creare colli di bottiglia, problemi di latenza e costi di trasferimento dati elevati. L’Edge Computing offre un’alternativa intelligente: elaborare i dati direttamente “al margine” (on the edge), cioè sul dispositivo stesso che li genera.

Immaginiamo uno scenario concreto: un agitatore orbitale o una centrifuga dotati di un sensore di vibrazioni. Invece di trasmettere un flusso continuo di dati vibrazionali al cloud, un microprocessore sul sensore stesso analizza i dati in tempo reale. Se rileva un pattern anomalo che indica uno sbilanciamento del carico (un rischio per la macchina e per i campioni), può inviare un allarme immediato o persino fermare l’apparecchio in autonomia. Solo i risultati pertinenti (es. “Anomalia rilevata alle 14:32”) o i riassunti statistici vengono inviati al sistema centrale, riducendo il traffico di rete del 99%.

Questo approccio ha tre vantaggi chiave per un laboratorio:

- Latenza zero: La risposta a un evento critico è istantanea, poiché non dipende dalla connessione internet. Questo è fondamentale per la sicurezza e la protezione dei campioni.

- Efficienza della larghezza di banda: Si riducono drasticamente i costi e i requisiti di infrastruttura di rete, un fattore importante in ambienti con molti strumenti connessi.

- Sicurezza dei dati: I dati grezzi e sensibili rimangono all’interno del dispositivo, riducendo la superficie di attacco per potenziali minacce informatiche.

L’Edge Computing, quindi, non è in contrapposizione al cloud, ma lo complementa. Permette di creare una rete di strumenti intelligenti e reattivi, dove ogni dispositivo agisce come un analista di primo livello, garantendo che solo le informazioni più importanti e actionable raggiungano il sistema centrale.

Piattaforme di collaborazione scientifica: come condividere dati sensibili tra università e aziende?

La scienza moderna è sempre più collaborativa. Progetti complessi richiedono l’unione di competenze provenienti da università, startup biotech e grandi aziende farmaceutiche. Tuttavia, questa collaborazione si scontra con una sfida enorme: come condividere dati sensibili (proprietà intellettuale, dati di pazienti) in modo sicuro e controllato? Inviare dataset via email o tramite servizi di file-sharing generici non è un’opzione praticabile né sicura. Un contesto come quello italiano, dove secondo il report SIM 2024 solo il 23% degli incubatori dichiara una specializzazione settoriale, rende la collaborazione trasversale ancora più necessaria per unire le competenze.

Le piattaforme di collaborazione scientifica nascono per risolvere questo problema. Si tratta di ambienti cloud sicuri, progettati specificamente per la ricerca. Queste piattaforme offrono diverse funzionalità chiave:

- Controllo granulare degli accessi: È possibile definire con precisione chi può vedere, scaricare o modificare specifici file o dataset. Un partner industriale potrebbe avere accesso ai risultati finali di uno studio, ma non ai dati grezzi.

- Spazi di lavoro virtuali: Ogni progetto ha un suo ambiente isolato, dove i team possono condividere dati, protocolli e analisi in modo sicuro, senza rischio di “contaminazione” tra progetti.

- Tracciabilità e audit trail: Ogni azione sulla piattaforma (accesso, download, modifica) viene registrata, fornendo una tracciabilità completa che è fondamentale per la conformità normativa e per la gestione della proprietà intellettuale.

- Integrazione con strumenti di analisi: Le piattaforme più avanzate permettono di eseguire analisi computazionali direttamente sui dati all’interno dell’ambiente sicuro, senza doverli scaricare in locale.

Adottare una di queste piattaforme significa creare un “trattato digitale” tra i partner di una collaborazione. Stabilisce regole chiare, garantisce la sicurezza e costruisce quella fiducia che è indispensabile per l’innovazione aperta. Invece di essere un ostacolo, la gestione sicura del dato diventa un acceleratore della collaborazione scientifica.

Per tradurre questi concetti in una strategia operativa, il passo successivo è avviare un’analisi dei flussi di lavoro nel vostro laboratorio per identificare le aree a più alto impatto per un progetto pilota di automazione.

Domande frequenti su Automazione nei laboratori biotech

Come garantire la conformità GMP nella produzione di ATMP?

Le norme di sterilità vengono rispettate posizionando le strumentazioni nelle zone di grado B, mentre le manipolazioni a cielo aperto avvengono sotto cappa a flusso laminare in area di grado A, dove il preparato è a contatto con l’ambiente. I sistemi automatizzati e chiusi garantiscono il mantenimento di queste condizioni in modo costante e documentato.

Quali sono i vantaggi di un sistema modulare integrato isolatore-incubatore?

La soluzione di un sistema modulare che integra isolatore e incubatore permette di eseguire la manipolazione asettica e l’espansione delle colture cellulari in un unico ambiente chiuso e controllato, riducendo drasticamente il rischio di contaminazione e ottimizzando l’uso dello spazio classificato in laboratorio.

Come ottimizzare lo spazio classificato limitato nei laboratori?

La transizione dalla coltura individuale alla produzione su larga scala spesso richiede spazi classificati aggiuntivi, che sono estremamente costosi. I sistemi di automazione compatti e impilabili, come gli incubatori modulari o le piattaforme integrate, permettono di massimizzare la produttività all’interno dello spazio di grado B già esistente, evitando costosi ampliamenti strutturali.